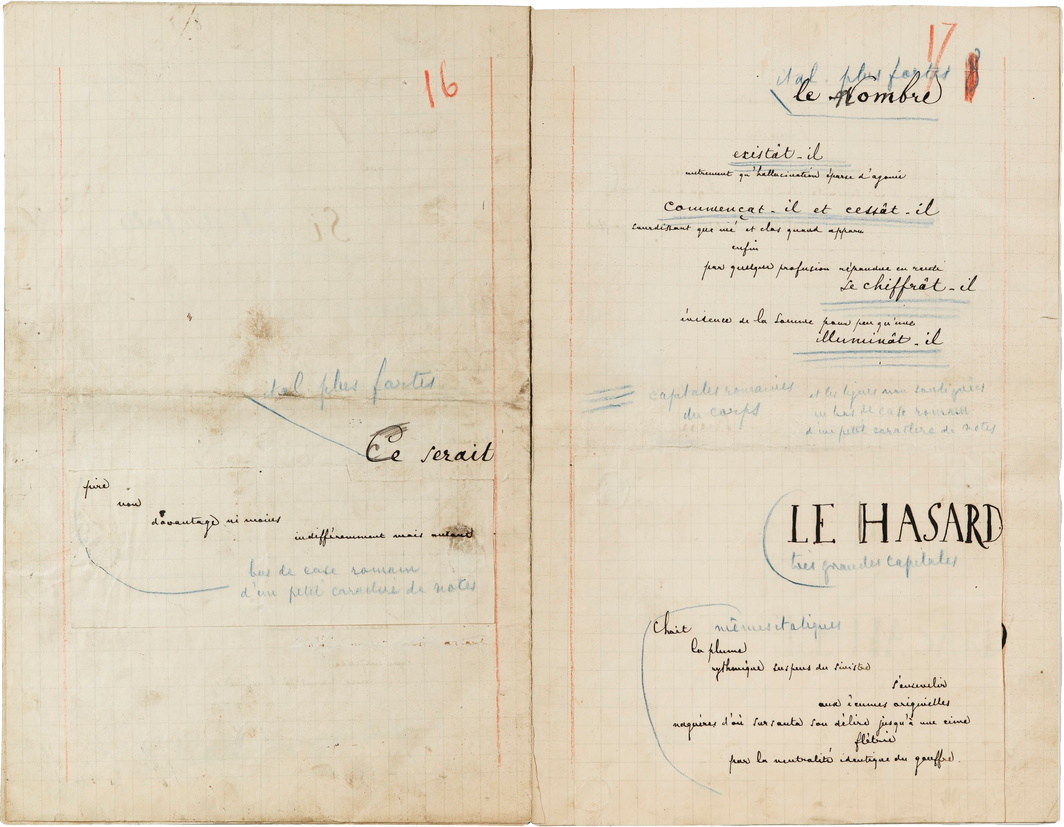

« Un Coup de Dés jamais n’abolira le Hasard »[1]

Pierre Gillis

Les platistes, les climato-sceptiques, les pourfendeurs de vaccins ont le vent en poupe, et leurs succès font des dégâts. L’antidote à ces perversions ne se trouve malheureusement pas en pharmacie, même avec une ordonnance en bonne et due forme. Mais l’inquiétude que ces succès suscitent provoque des réactions sous forme de vademecum, de mode d’emploi de pensée critique, de tuto, comme on dit aujourd’hui. Nous avons bénéficié d’une de ces interventions préventives, lors de notre colloque « Le grand bazar de l’irrationnel », en octobre 2019, de la part de Virginie Bagneux[2] : des biais perceptifs ou cognitifs à la submersion émotionnelle et aux corrélations arbitraires, les voies des convictions sans fondement sont nombreuses et souvent impénétrables.

Il y a plus longtemps, j’avais apprécié une tentative comparable sous la plume de Normand Baillargeon, auteur d’un petit cours d’autodéfense intellectuelle[3], illustré par Charb, qui a payé de sa vie son engagement dans la lutte contre l’obscurantisme. En quatrième de couverture, Noam Chomsky encourageait vivement l’auteur : « Si nous avions un vrai système d’éducation, on y donnerait des cours d’autodéfense intellectuelle. »

Ces manuels d’éveil de l’esprit critique consacrent un volume de pages non négligeable au bon usage des statistiques. Il est vrai qu’elles ont mauvaise réputation : on pourrait leur faire dire n’importe quoi, ceux qui l’ont dit et répété sont en si grand nombre qu’il est difficile d’attribuer un auteur à cette rodomontade, elle-même plus révélatrice des capacités retorses de certains polémistes que de la nature profonde de la partie des mathématiques qu’on appelle statistique. L’attaque la plus ancienne, en tout cas à ma connaissance, est celle du premier ministre britannique de la Reine Victoria, Disraeli, qui aurait déclaré qu’« il y a trois sortes de mensonges : le mensonge ordinaire, le parjure et les statistiques. » Un peu plus tard, Mark Twain ne transforme que légèrement la formule : « Il y a trois sortes de mensonges : les mensonges, les sacrés mensonges et les statistiques. » Winston Churchill fait davantage dans le cynisme, fidèle à son personnage : « Je ne crois aux statistiques que lorsque je les ai moi-même falsifiées. » Je vous fais grâce des versions plus récentes.

Il est vrai que la tentation est grande de décréter incompatibles la rigueur de la pensée mathématique et les aléas de la contingence et du hasard. Patrick Tort a remarquablement posé le problème dans son ouvrage de refondation du matérialisme[4]. On parle de contingence, écrit-il, lorsqu’un évènement peut advenir – ou non. On dit alors que cet évènement se produit par hasard. Invoquer le hasard, c’est d’abord adopter un point de vue partial à son sujet : Gustave-Adolphe, roi de Suède, a été tué à 38 ans à la bataille de Lützen, en 1632, emporté par un boulet de canon. La bataille fut cependant gagnée par les Suédois, mais les conséquences de la mort de Gustave-Adolphe, souverain d’un des royaumes les plus puissants en Europe, furent énormes sur la politique européenne. On parla de hasard terrible pour qualifier sa mort. Mais personne n’aurait, bien sûr, pensé que la mort des 10 000 soldats au cours de la même bataille ait pu être le fait du hasard. Sauf un proche d’un de ces soldats… On ne parle du hasard que pour attribuer du sens à un évènement dont la cause nous échappe, et encore, du point de vue subjectif de celui qui s’exprime. C’est une subjectivité du même ordre, aussi forte, qui amène à nier le hasard : face à un évènement non maîtrisé, non prévu, la pulsion égotiste qui refuse l’arbitraire de l’évènement amène à nier tout hasard dans son advenue. Ainsi, les expressions antagonistes « c’est un hasard » et « ce n’est pas un hasard » relèvent toutes deux d’une exacerbation de la subjectivité, et annihilent la notion de hasard, pour exclure qu’un évènement soit dépourvu de sens pour quiconque ou voulu par personne. La notion commune de hasard est ainsi consubstantielle d’un point de vue finaliste sur le monde : « pour une pensée finaliste, “il n’y a pas de hasard”, au sens où il n’y a pas de déterminisme indifférent »[5]. Mais il y a un déterminisme de l’horloger du monde, qui sait ce qu’il veut. C’est ce déterminisme « intentionnel » que Darwin bannit de la science biologique, qui se construit contre l’« ego » finalisateur de chacun, et contre la téléologie.

Le hasard, mesure de notre ignorance ?

Le mathématicien Antoine-Auguste Cournot (1801-1877), cité par Tort, donne une autre signification, moins subjective, au hasard : « L’idée du concours de plusieurs séries de causes indépendantes pour la production d’un évènement est ce qu’il y a de caractéristique et d’essentiel dans la notion du hasard ». Il se plaçait ainsi dans la lignée de Laplace, qui avait écrit, quelques années auparavant : « Le hasard n’a donc aucune réalité en lui-même : ce n’est qu’un terme propre à désigner notre ignorance sur la manière dont les différentes parties d’un phénomène se coordonnent entre elles et avec le reste de la nature. La notion de probabilité tient à cette ignorance. »[6] Affirmation claire, souvent vérifiée et pertinente, mais la physique contemporaine a cependant conféré un sens plus fondamental à la notion de probabilité.

Les tenants de la synchronicité – un des plus célèbres parmi eux fut l’analyste jungien Guy Corneau (1951-2017) – font partie de la cohorte des donneurs de sens à tout prix, pour qui le hasard n’existe pas. Pour faire court, la synchronicité, c’est le fait d’avoir avec certaines personnes les mêmes envies, les mêmes idées, les mêmes démarches dans le même temps. Il nous arrive de décrocher le téléphone et que notre interlocuteur nous dise : « C’est fou, j’allais t’appeler ». Cette coïncidence, pour les synchronicistes, serait explicable par l’effet d’une causalité rétrograde, remontant le cours du temps… La volonté de faire sens est sans limite !

Face à de telles dérives, on admettra que la nécessité de cerner les effets du hasard s’impose aux éveilleurs d’esprit critique. Le physicien Hubert Krivine s’est lancé dans l’entreprise en publiant un passionnant Petit traité de hasardologie[7], qui présente un ensemble rare de qualités primordiales : son traité est rigoureux, complet, compréhensible et amusant – on en redemande.

Les faux nez des causalités abusives

On y trouvera, bien entendu, un éventail d’évènements corrélés, entre lesquels on établit trop facilement un lien de cause à effet. Un chapitre leur est consacré, le troisième, intitulé Post hoc, ergo propter hoc ? ̶ « à la suite de cela, donc à cause de cela ? », en français dans le texte. Les discussions socio-politiques sont particulièrement riches en glissements de ce type, et les économistes particulièrement visés par Krivine : « en Allemagne où la durée du travail est réputée supérieure à celle de la France, le chômage est inférieur » (p. 71), cherchez l’erreur. Question d’invoquer un exemple que je n’ai pas pioché chez lui, je me rappelle qu’à l’époque où j’étais chargé d’initier les futurs médecins de l’UMONS aux joies de la statistique, j’avais déniché un tableau de données qui donnait parallèlement, en Grande-Bretagne et de 1972 à 1997, l’évolution du nombre d’admissions en hôpital psychiatrique et celle du nombre de récepteurs de télévision chez les particuliers. Les deux séries étaient en progression régulière sur le quart de siècle recensé, et le calcul de leur coefficient de corrélation donnait 0,99 – valeur très élevée, témoin d’une forte corrélation. Conclusion facile : la télévision rend fou. Est-il possible de proposer un lien de cause à effet inversé ? Possible, et libre à vous d’en concocter un autre, mais « l’explication » est plus tordue, et passe moins bien la rampe : lorsque le nombre d’aliénés augmente fortement, les personnes saines d’esprit affectées par un voisinage dérangeant sont aussi en nombre croissant, et ces personnes cherchent un dérivatif en passant beaucoup de temps devant leur télévision. Thèse suffisamment peu crédible pour mettre en doute le lien de cause à effet, de sorte qu’on en vient facilement à l’idée que le lien de cause à effet soi-disant déduit est arbitraire, et que simplement la société britannique a simultanément vu, de 1972 à 1997, les deux paramètres augmenter considérablement, pour des raisons sur lesquelles les sociologues peuvent décider de se pencher pour, éventuellement, les expliquer – indépendamment l’un de l’autre.

On se tromperait cependant à réduire ce Petit traité de hasardologie à la dénonciation de travers suffisamment connus pour figurer dans les bêtisiers du genre visé. L’ambition est plus élevée, et d’ordre didactique : on nous montre d’abord comment la notion de probabilité est définie, à partir de la mesure de la fréquence de réalisation d’un évènement aléatoire (le rapport entre le nombre de fois qu’il se réalise et le nombre de fois que l’expérience au cours de laquelle il pourrait se réaliser est tentée), la probabilité étant la limite de cette fréquence lorsque le nombre de tentatives effectuées s’accroit indéfiniment, ce qui, en pratique, n’est pas toujours facile à mettre en œuvre.

À partir de là, Hubert Krivine nous guide pour nous permettre d’éviter bon nombre de chemins (trop) souvent parcourus et débouchant sur des contresens. Ainsi, il cite l’astrologue et docteure de la Sorbonne (!) Elizabeth Tessier ; celle-ci s’efforce de démontrer la puissance de son pouvoir divinatoire en écartant la possibilité que l’avènement d’une de ses prédictions soit simplement l’effet du hasard. Pour ce faire, elle attribue à l’occurrence d’un évènement qui peut se produire ou ne pas se produire, comme chacune de ses prédictions, une probabilité de ½ – une chance sur deux qu’il se produise. Faux, évidemment : il suffit de penser à une liaison aérienne et à la possibilité qu’un accident la frappe, ce qui peut en effet arriver, ou pas ; chacun sait que la probabilité que l’accident se produise est heureusement nettement plus petite que ½…

Des raisonnements souvent subtils

Les choses se compliquent lorsqu’on s’intéresse aux probabilités relatives à des événements multiples, connaissant les probabilités des étapes qui les constituent. Naissances multiples, par exemple, et questionnement sur quelques cas de figure qui préoccupent les familles : filles ou garçons ? Plus d’accouchements les nuits de pleine lune ? Non, légende, démentie par des statistiques sérieuses, mais néanmoins colportée par des sages-femmes, toutes professionnelles qu’elles soient. Je reste cependant dubitatif sur la réponse proposée à une question posée dans la foulée : « Dans certaines traditions, il est essentiel pour les couples d’avoir au moins un garçon. Aussi tous les couples dont le premier enfant est une fille continuent à avoir des enfants jusqu’à la naissance d’un garçon. Ce comportement change-t-il le sex ratio ? » (p. 18) Réponse détaillée dans l’annexe 3 : non. Dubitatif, parce que la démonstration repose sur une hypothèse, certes raisonnable, mais discutable dans le cas précis (Krivine ne manque d’ailleurs pas de le signaler) : toute femme enceinte a une chance sur deux pour que le bébé dont elle va accoucher soit une fille (ou un garçon, bien sûr). On peut au contraire se dire que lorsqu’un couple engendre des filles à répétition, et persévère jusqu’à donner naissance à un héritier mâle (ou jusqu’à épuisement), on peut suspecter un problème physique qui empêcherait la formation d’un embryon mâle, ou qui en diminuerait la probabilité. Auquel cas l’hypothèse de base serait erronée. Et le résultat pourrait être un accroissement du nombre de filles – au point de modifier le sex ratio ? Je n’en sais rien : encore faudrait-il que le phénomène ait une ampleur dont nos sociétés standardisées quant au nombre d’enfants par couple ne semblent pas pouvoir être le cadre. L’intérêt de la discussion est de montrer le lien entre la conclusion et l’hypothèse qui fonde la possibilité du calcul.

Autre biais de raisonnement pointé : échantillon faussé – l’effet Coluche, en référence à la célèbre citation de ce dernier : n’allez surtout pas à l’hôpital, on a trois fois plus de chances d’y mourir qu’à la maison. Certes, mais en général, quand on va à l’hôpital, c’est parce qu’on n’est pas en bonne santé ; la comparaison met en balance deux groupes, l’un majoritairement composé de malades, et l’autre pas. Autre exemple du même tonneau, moins caricatural : « Ceux qui pratiquent régulièrement le jogging à 60 ans ont plus de chances d’être en bonne santé à 70 ans que la population en général. » Oui, mais ils étaient souvent déjà en meilleure santé à 60 ans, puisqu’ils pratiquent le jogging, ce dont ne sont pas capables tous les sexagénaires.

Il est parfois absurde de discuter la moyenne d’une distribution. Deux exemples pour illustrer : en moyenne, chaque humain a une couille. Ou encore, au Vatican (État dont la superficie est de 0,44 km²), il y a 2,3 papes au km² (p. 24).

Le traité de hasardologie contient encore bien d’autres informations et réflexions utiles et stimulantes, débouchant en général sur des conseils de prudence quant aux affirmations souvent péremptoires, résumant des conclusions qui mériteraient davantage de nuances. Je ne les passerai pas toutes en revue, laissant celles et ceux que j’aurais alléchés se procurer le bouquin et le lire. Et ne manquez pas le passage consacré aux tests et à leurs faux positifs et négatifs (pp. 44-45) : pour que le test soit significatif, il faut que la probabilité d’erreur associée à la mesure effectuée soit sensiblement inférieure à la probabilité de la maladie.

Les séries statistiques débutent plus souvent par 1 que par 2…

Je dois cependant confesser une inculture personnelle regrettable, à propos de la loi de Benford, que j’ignorais, à ma grande confusion, et que j’ai découverte au cours de ma lecture. Au contraire de lois imaginaires, ce que sont souvent les pseudo-lois des séries, la loi de Benford est réelle et vérifiée, elle qui « stipule que si vous regardez le premier chiffre des nombres qui apparaissent dans bien des statistiques, vous trouverez davantage de 1 que de 2, de 2 que de 3, etc. » (p. 48) On aurait plutôt une tendance spontanée à les penser également répartis… La raison profonde de cette inhomogénéité est à situer dans le fait que ces séries de données concernent des nombres qui peuvent aussi bien se trouver dans des intervalles de valeurs très petites, des fractions d’unités, que très grandes, des millions ou des milliards. Sur une échelle linéaire, celle que nous sommes habitués à utiliser, les intervalles couverts par des millions sont considérablement plus grands que ceux couverts par des fractions d’unités ; sur une échelle qui rende lisible un ensemble de données qui irait de 1 à 10 millions, par exemple, un intervalle qui s’étendrait de 1 à 10 serait plaqué sur un seul point. Illisible, et sans signification : la seule manière de prendre en compte simultanément des intervalles correspondant à des ordres de grandeur différents est d’utiliser une échelle logarithmique, sur laquelle la distance entre 1 et 2 est plus grande que celle entre 2 et 3, elle-même plus grande que celle entre 3 et 4, etc. Faites l’exercice, vous serez convaincus !

Un hasard irréductible et bienvenu

Laplace et Cournot, voir les citations ci-dessus, font du hasard la mesure de notre ignorance. C’est incontestable quand on pense à un lancer de dés : on pourrait certainement construire une machine qui lance un dé de manière reproductible, sur un support bien étudié, le résultat étant alors la conséquence directe des conditions initiales du jet – comment le dé est-il déposé dans la machine avant d’être projeté.

La mathématique et la physique sont arrivées à théoriser nos ignorances, et à y mettre un peu d’ordre, en développant les statistiques : la température est un concept qui n’a aucun sens pour une molécule bien ciblée, qu’elle soit isolée ou pas, et pourtant chacun admettra que ce concept a depuis longtemps prouvé sa pertinence et son utilité. C’est exactement ce qu’Henri Poincaré, cité par Krivine (p. 95), disait, à propos d’un phénomène se déroulant à l’échelle macroscopique, celle de notre vie de tous les jours :

Si par malheur, je connaissais les lois de ce phénomène, je ne pourrais y arriver [à prédire ce qui va se produire] que par des calculs inextricables et je devrais renoncer à vous répondre ; mais comme j’ai la chance de les ignorer, je vais vous répondre tout de suite. Et, ce qu’il y a de plus extraordinaire, c’est que ma réponse sera juste.

Les développements scientifiques nous ont conduits à prendre nos distances avec le point de vue Laplace-Cournot, dans deux domaines distincts : le chaos déterministe et la mécanique quantique. Le chaos déterministe, c’est le contexte qui a donné naissance à l’image du battement de l’aile d’un papillon au Brésil, susceptible de déclencher une tornade au Texas. Je continue cependant à me méfier du lien de cause à effet direct que le terme « déclencher » établit entre le battement de l’aile et la tornade : stricto sensu, ce n’est pas l’aile du papillon qui déclenche la tornade, mais l’ensemble des conditions déterminant l’état de l’atmosphère, des océans, etc. Et on parle de chaos parce qu’une infime modification de ces conditions, comme un battement d’aile de papillon, peut changer radicalement l’état général futur du système – par exemple, sous la forme de l’apparition d’une tornade. Pourtant, dans le cas des systèmes chaotiques, les lois qui président à l’évolution du système sont censées connues, et absolument déterministes.

La théorie du chaos ne supprime pas la causalité, simplement, elle introduit une distinction qui n’était pas évidente entre déterminisme (on connaît la loi d’évolution) et prévisibilité au-delà d’un certain délai. (p. 102)

Pour être complet, on ajoutera qu’un système ne doit pas être compliqué pour être chaotique. Ainsi, la mécanique s’est intéressée depuis longtemps au problème dit à 3 corps (interagissant via la gravitation universelle, bien connue), pour conclure qu’il est chaotique. L’impossibilité de prédire l’avenir du système à long terme n’est pas réductible à l’ignorance des lois qui régissent son évolution.

Deuxième réhabilitation du hasard, la mécanique quantique. Le hasard qui préside à la décomposition radioactive d’un noyau instable est irréductible, les tentatives de l’éliminer au profit d’une causalité sous-jacente ont fait long feu. Ce qui ne prive toutefois pas la mécanique quantique de sa capacité à faire des prédictions d’une précision invraisemblable, là où elle déploie sa puissance théorique, dans son domaine de pertinence (p. 110). Mais ceci est un autre sujet, qui fait l’objet de débats passionnés et de vulgarisations plus ou moins réussies.

Terminons par une remarque qui valorise les évènements rares, éloignés de la moyenne, typiques des fluctuations d’un système :

L’évolution (et pas seulement celle des espèces vivantes) est rendue possible par les fluctuations. Elles seules permettent d’explorer des domaines qui seraient inaccessibles si les grandeurs en jeu restaient toutes voisines de leur valeur moyenne. » (p. 84)

Jusqu’à fonder un modèle d’émergence de l’univers à partir des fluctuations du vide quantique[8] – ce qui, on en conviendra, est loin de renvoyer le hasard des fluctuations à l’obscurité de nos ignorances ou à l’insignifiance d’un détail sans importance.

Le hasard avait bien besoin d’être réexploré, et Hubert Krivine remercié pour l’avoir fait avec talent.

Notes

- Titre d’un poème en vers libres de Stéphane Mallarmé, Cosmopolis 17, Paris, éditeur Armand Collin, 1897. ↑

- Virginie Bagneux, « Croyances (ir)rationnelles : esprit critique es-tu là ? », in Le grand bazar de l’irrationnel, sous la direction de Patrice Dartevelle, Bruxelles, ABA Editions, 2020, pp. 65-103. ↑

- Normand Baillargeon, Petit cours d’autodéfense intellectuelle, Montréal, Lux, 2006. ↑

- Patrick Tort, Qu’est-ce que le matérialisme ? Introduction à l’Analyse des complexes discursifs, Paris, éditions Belin, 2016, pages 66 et suivantes. ↑

- Patrick Tort, Idem, p. 72. ↑

- Pierre-Simon de Laplace, Mémoires de mathématique et de physique présentés à l’Académie des sciences, vol. 7, 1776. ↑

- Hubert Krivine, Petit traité de hasardologie, Paris, Cassini, 2018, 164 pages. ↑

- Voir Edgard Gunzig, « Histoire cosmologique du vide », in Le briquet du Tout-Puissant a-t-il allumé le Big Bang ? », Bruxelles, ABA Editions, 2017, pp. 49-73. ↑

Vous devez être connecté pour commenter.